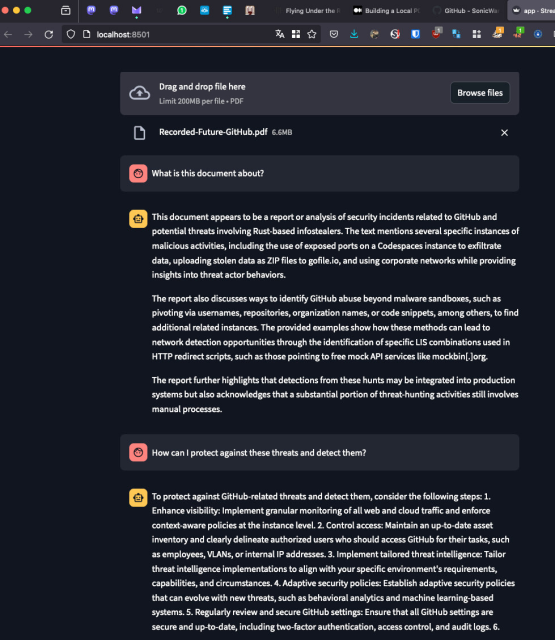

No soy el mayor fan de la #IA ni mucho menos (consideraciones éticas aparte creo que hay todavía mucho hype y pocas nueces), pero también pienso que una parte de todo lo que está saliendo en este boom terminará quedándose a la larga. Me interesa sobre todo cacharrear con las capacidades de una instancia privada en local y he terminado montando un proyectillo que me he encontrado por Github para construir un pequeño chatbot para analizar documentos PDF construido sobre #ollama como motor y Mistral como #LLM. Aunque ya le he pillado cierta tendencia al invent es una herramienta curiosa e incluso potencialmente útil. Es relativamente sencillo de montar una vez superas el infierno de dependencias de Python que te exige downgradear algún módulo pero consume recursos que no veas. Un Mac Mini con un M2 sufre ante cada pregunta. Ha sido también útil para entender los recursos que exige una IA generativa con un LLM modesto y, una vez más, sospechar de quien te dé esto gratis como servicio. Si tenéis curiosidad por probarlo vosotros mismos, aquí tenéis el proyecto que me he clonado: github.com/SonicWarrior1/pdfch…

GitHub - SonicWarrior1/pdfchat: Local PDF Chat Application with Mistral 7B LLM, Langchain, Ollama, and Streamlit

Local PDF Chat Application with Mistral 7B LLM, Langchain, Ollama, and Streamlit - GitHub - SonicWarrior1/pdfchat: Local PDF Chat Application with Mistral 7B LLM, Langchain, Ollama, and StreamlitGitHub

This entry was edited (2 years ago)